Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №125 /llama/

Аноним

27/04/25 Вск 21:17:25

№

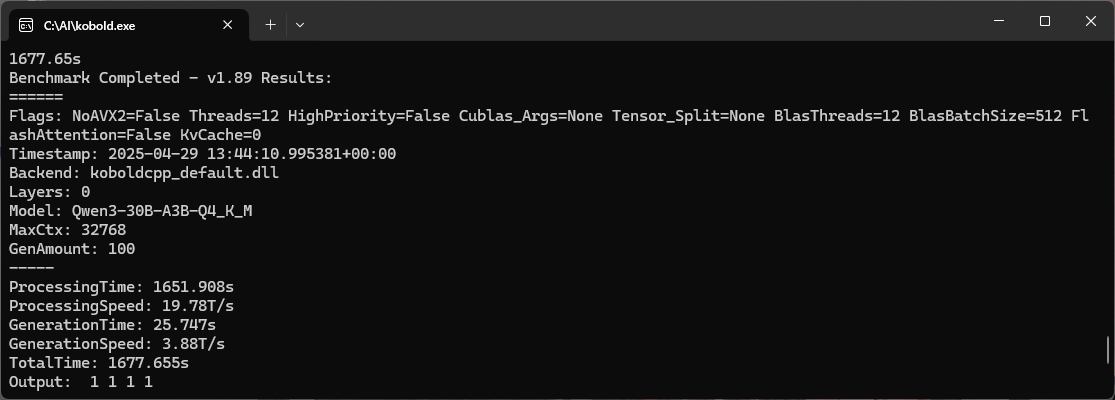

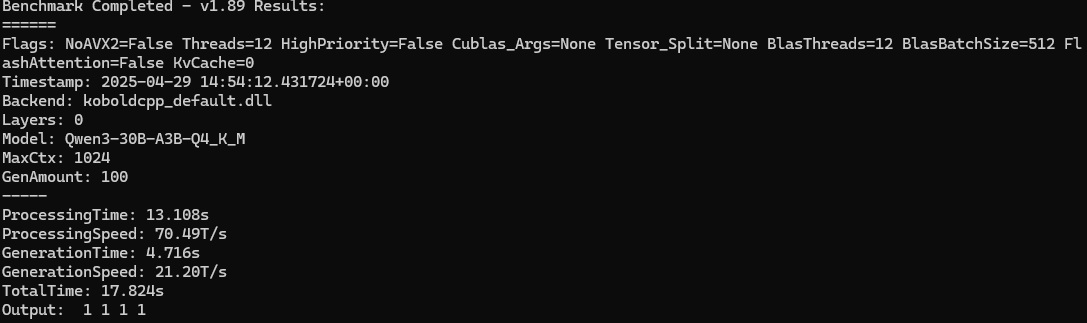

1